人工知能の歴史は、古代の神話における神のごとき名工が、人工物に知性や意識を授けたという逸話にまでさかのぼることができると言われる。英文学修士であり技術哲学・科学哲学の作家でもあるパメラ・マコーダックは、人工知能(AI)の起源について「神を人の手で作り上げたいという古代人の希望」が起こった時と表現している。

現代的な意味での人工知能は、人間の思考過程を記号の機械的操作として説明することを試みた哲学者に始まる。1940年代に数学的推論の抽象的本質にもとづいたマシン、プログラム可能なデジタルコンピュータの発明もその延長線上にある。この装置とその背後にある考え方に触発された科学者はほんの一握りだったが、それでも彼らは電子頭脳を構築する可能性を真剣に議論しはじめた。

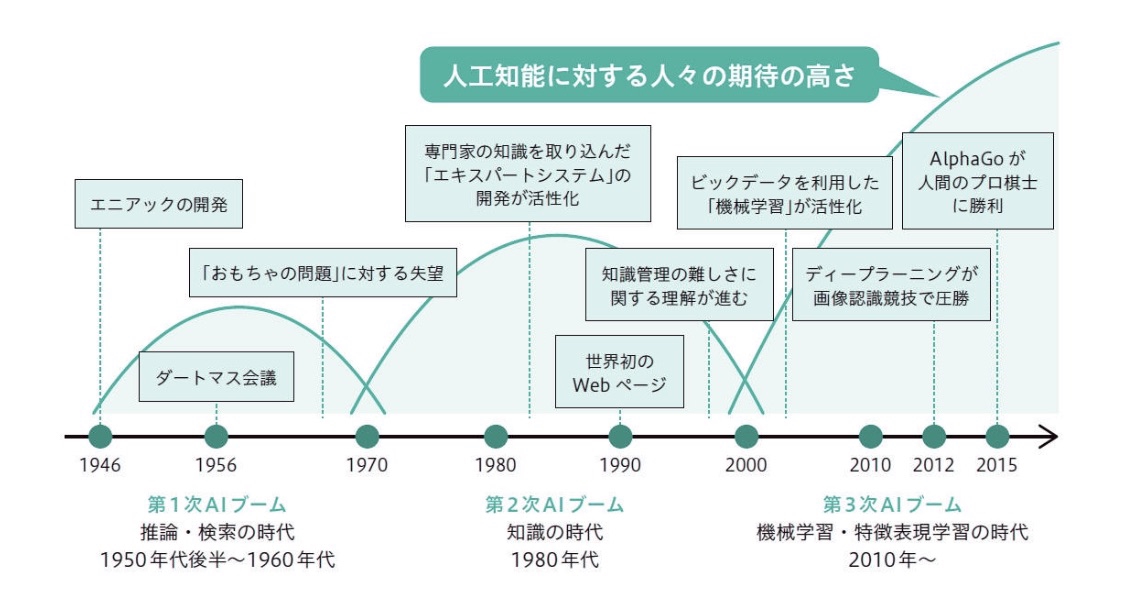

人工知能の研究が学問分野として確立したのは、1956年夏にダートマス大学のキャンパスで開催された会議がきっかけである。その後のAI研究を牽引したのがこの会議の参加者たちであり、彼らの多くは、人間と同程度に知的なマシンが自分たちが生きているうちに出現するだろうと考え、むしろそのビジョンを実現させるためにあらそって数百万ドルの資金を獲得した。しかしその結果明らかになったのは、彼らのプロジェクトが当分は実現できいであろうという予測だった。1973年にはジェームス・ライトヒルが主導したて政界から圧力がかかり、アメリカでもイギリスでも成果の見えない人工知能関連の研究への出資を終了した。それでも日本では官民問わず500億円以上の資金が人工知能の研究に注がれたが、やはり成果は出ず失望した投資者たちは80年代末には資金をひきあげた。このように人工知能をめぐる「夏と冬」は繰り返されてきたといってよい。しかし現代でも人工知能については「大胆な」予測をする人々は後をたたない。

官僚やベンチャー・キャピタリストの間で評価がいりみだれてきたにもかかわらず、実際に人工知能の研究は発展しつづいている。1970年代には解決不可能と思われていた問題にも糸口が見つかり、具体的な商品にも応用されるようになっていった。しかし、第一世代の人工知能の研究者らの楽観的予測に反して、強いAIを持つマシンの構築は実現していない。1950年の有名な論文でも、アラン・チューリングは「我々はほんの少し先しか見ることができない」と認めていた。「それでも」と彼は続けている。その少し先に「我々がなすべきことが数えきれないほど浮かんでくる」

前史

McCorduck (2004) では「何らかの形態の人工知能は、西洋精神史に広くみられる考え方で、速やかな実現が望まれている夢」だとし、神話、伝説、物語、思索、機械仕掛けのオートマタなどで表現されてきたとされている。

神話やフィクションにおけるAI

ギリシア神話に見られる機械人間や人工生命体としては、ヘーパイストスの黄金のロボットやピュグマリオーンのガラテイアがある。中世には物体に精神を植えつける神秘主義的秘術や錬金術的方法の噂があり、ジャービル・イブン=ハイヤーンの Takwin、パラケルススのホムンクルス、イェフダ・レーヴ・ベン・ベザレルのゴーレムなどが知られている。19世紀には、人造人間や思考機械というアイデアがフィクション内で発展し、メアリー・シェリーの『フランケンシュタイン』やカレル・チャペックの『R.U.R.(ロッサム万能ロボット会社)』が登場。思索面ではサミュエル・バトラーの "Darwin among the Machines" がある。以降、AIは現在に至るまでサイエンス・フィクションにおける重要な要素の1つとなっている。

オートマタ

写実的な人間型オートマタは、様々な文明で職人が製作している。例えば、周の穆王の時代の偃師、アレクサンドリアのヘロン、アル=ジャザリ、ヴォルフガング・フォン・ケンペレンなどがいる。既知の最古のオートマタとしては、古代エジプトや古代ギリシアの神聖な彫像がある。信者はそれらの彫像に職人が知恵と感情を伴う本当の心を吹き込んだと信じた。ヘルメス・トリスメギストスは、「神の真の性質を発見することで、彼らはそれを再現することができた」と記している。

形式的推論

人工知能は、人間の思考過程を機械で再現できるという前提に基づいている。機械的あるいは形式的推論の歴史は長い。中国、インド、ギリシアの哲学者らは、いずれも紀元前に形式的推論の構造化された手法を発展させた。その発展に寄与した哲学者としては、アリストテレス(三段論法を定式化して分析した)、エウクレイデス(その『原論』は形式的推論の原型となった)、フワーリズミー(代数学を発展させ、その名は「アルゴリズム」として残っている)、ヨーロッパスコラ学の哲学者であるオッカムのウィリアムとヨハネス・ドゥンス・スコトゥスなどが挙げられる。

マジョルカ人哲学者ラモン・リュイ (1232–1315) は論理的方法で知識を生み出すことを意図した「論理機械」をいくつか開発した。リュイは自身の機械について、単純な論理操作で基本的かつ紛れもない真理を結合する機械的要素群であり、機械的手段で生み出された真理が考えられるあらゆる知識を生み出すとした。リュイの業績はゴットフリート・ライプニッツに大きな影響を及ぼした。

17世紀になると、ライプニッツ、トマス・ホッブズ、ルネ・デカルトらはあらゆる理性的思考は代数学や幾何学のように体系化できるのではないかという可能性を探究した。ホッブズは『リヴァイアサン』で「推論は計算以外のなにものでもない」と記している。ライプニッツは推論のための汎用言語 (characteristica universalis) を想像し、論証を計算に還元しようと考えた。それによって「2人の哲学者の論争は2人の会計士の論争程度のことになる。彼らは論証を石版に書き記し(必要な友人を証人に立て)『計算』してみればよい」とした。これらの哲学者の考え方から物理記号システム仮説が明確化していき、それがAI研究の指針となった。

20世紀になると、数理論理学の研究が人工知能の実現可能性への根本的なブレークスルーを提供する。その基盤となったのは、ブールの The Laws of Thought とフレーゲの『概念記法』である。フレーゲの体系に基づき、1913年、ラッセルとホワイトヘッドが重要な著作『プリンキピア・マテマティカ』において数学的基礎の形式的記述を行った。ラッセルの成果に触発されたダフィット・ヒルベルトは、当時の数学者らに「数学におけるあらゆる推論は形式化できるか?」という根本的問題を提示した(ヒルベルト・プログラム)。この問題への解答が、ゲーデルの不完全性定理、チューリングの機械、チャーチのラムダ計算である。その解答は2つの意味で驚くべきものだった。第一に彼らは数理論理が成し遂げられることには限界があることを証明した。

第二に(こちらがAIにとっては重要)、彼らの業績が意味するのは、その限界の中でなら任意の数学的推論を機械化できるという事実だった。チャーチ=チューリングのテーゼでは、0と1といった単純な記号群だけで任意の数学的推論過程を模倣できることが暗示されている。鍵となる洞察はチューリングマシンであり、記号操作を抽象化した単純な理論上の機械である。チューリングマシンは一部の科学者が思考する機械の可能性を議論しはじめるきっかけとなった。

計算機科学

計算機械は古代から作られており、歴史の進展と共にゴットフリート・ライプニッツなど多くの数学者が洗練させていった。19世紀初め、チャールズ・バベッジはプログラム可能な計算機を設計したが(解析機関)、実際には製作しなかった。エイダ・ラブレスはその機械が「精巧で科学的な音楽の断片をそれなりの複雑さと長さで作曲するかもしれない」と推測した。エイダ・ラブレスはその機関でベルヌーイ数を計算する方法を詳細に注記したことから、世界初のプログラマと言われている。

世界初の現代的コンピュータ(Zuse Z3、ENIAC、Colossus)は第二次世界大戦の際に開発された。その後アラン・チューリングの理論的基礎をジョン・フォン・ノイマンが発展させた形でコンピュータが発達していった。

人工知能の誕生 1943−1956

- 以降の節の表題についての注

1940年代と1950年代、様々な分野(数学、心理学、工学、経済学、政治学)出身の一握りの科学者が人工頭脳(artificial brain)を作る可能性を議論し始めた。人工知能研究は1956年に学問分野として確立された。

サイバネティクスと初期のニューラルネットワーク

思考機械についての最初の研究は、1930年代末から1950年代初期にかけて流行ったいくつかのアイデアをまとめるところから着想された。当時最新の神経学の成果で、脳は神経細胞の電気ネットワークであり、全てか無かというパルスで点火されるということがわかった。ノーバート・ウィーナーのサイバネティックスは、電気ネットワークにおける制御と安定性を扱っていた。クロード・シャノンの情報理論はデジタル信号(全てか無かの信号)を扱っていた。アラン・チューリングの計算理論は任意の計算をデジタルで表せることを示した。これらの相互に密接に関連したアイデアが電子頭脳構築の可能性を示唆していた。

この文脈での業績例として、ウィリアム・グレイ・ウォルターの亀や Johns Hopkins Beast のようなロボットがある。それらの機械はコンピュータもデジタル電子回路も記号推論も使っておらず、完全にアナログ電子回路のみで制御されていた。

ウォルター・ピッツとウォーレン・マカロックは理想化した人工神経細胞のネットワークを解析し、どうやって単純な論理関数のような働きをするのかを示した。それが後の研究者らにニューラルネットワークと呼ばれるものの最初の研究である。ピッツとマカロックに触発された学生の1人に若きマービン・ミンスキー(当時24歳の学生)がいた。1951年、ミンスキーは世界初のニューラルネットマシンSNARCを構築した。ミンスキーはその後50年間、AI界の重要なリーダーの1人となった。

ゲームAI

1951年、マンチェスター大学の Ferranti Mark 1 というマシンを使い、クリストファー・ストレイチーがチェッカープログラムを、ディートリッヒ・プリンツがチェスのプログラムを書いた。アーサー・サミュエルは1950年代中ごろから60年代初めにかけてチェッカーのプログラムを開発し、まともなアマチュアと互角に渡り合える程度のスキルを身につけるようになった。ゲームAIはその後もAIの進化の程度を測る手段として使われることになった。

チューリングテスト

1950年、アラン・チューリングは記念碑的論文 Computing Machinery and Intelligence を発表し、真の知性を持った機械を創りだす可能性について論じた。彼は「知性」を定義するのは難しいとして、有名なチューリング・テストを考案した。テレタイプ端末を介した機械との対話が人間との対話と区別できない場合、その機械は「知的」だといえる。このように問題を単純化したことでチューリングは少なくとも「もっともらしい」「思考機械」の可能性を説得力のあるものとして主張でき、この論文は全ての一般的な反論に答えた。チューリング・テストは人工知能の哲学における最初の真面目な提案となった。

記号的推論と Logic Theorist

1950年代中ごろにコンピュータにアクセス可能になると、一部の科学者は数を操作できる機械は記号も操作でき、記号の操作は人間の思考の本質を表しうると直観的に気付いた。それが思考機械に迫る新たな手法となった。

1955年、アレン・ニューウェルと(後にノーベル賞を受賞した)ハーバート・サイモンは(クリフ・ショーの助けも得て)"Logic Theorist" を作った。このプログラムはラッセルとホワイトヘッドの『プリンキピア・マテマティカ』の最初の方にある52の定理のうち38の定理を証明してみせ、そのうち一部は新たな洗練された証明方法を見出した。サイモンは彼らが「かの心身問題を解決し、物質で構成されているシステムが精神の特性をどのようにして持つことができるかを説明した」と述べている。これは、後にジョン・サールが「強いAI」と呼んだ哲学的立場(機械は人間の身体と同じように精神を持ちうる)を表した初期の文章の1つである。

ダートマス会議 (1956): AIの誕生

1956年のダートマス会議は、マービン・ミンスキーとジョン・マッカーシー、さらに2人よりやや年上のクロード・シャノンとIBMのナサニエル・ロチェスターが準備し組織した。この会議の提案書には「学習のあらゆる面または知能の他のあらゆる機能は正確に説明できるので、機械でそれをシミュレートすることができる」と書かれていた。会議参加者としては他に、レイ・ソロモノフ、オリバー・セルフリッジ、トレンチャード・モア、アーサー・サミュエル、アレン・ニューウェル、ハーバート・サイモンがおり、いずれもAI研究の最初の十年間で重要なプログラムを作った人々である。この会議でニューウェルとサイモンが Logic Theorist を初めて公表し、マッカーシーがその分野の名称を "Artificial Intelligence" にしようと説得した。1956年のダートマス会議でAIには名前がつけられ、目標が与えられ、最初の成功例が見られ、主なプレーヤーが揃った。そのため、これをAIの誕生とするのが一般的である。

第1回AIブーム: 推論と探索の時代 1956年−1974年

ダートマス会議後の数年は発見の時代で、新たな地平を疾走するような勢いだった。この時代に開発されたプログラムは推論と探索に頼っており、巨額を投じて開発された当時の最高峰のコンピュータであっても、処理可能な計算量はごく僅かであったため、非常に限定的な領域の問題しか解けなかったが、それでも当時の人々にとっては「驚異的」だった。コンピュータは代数問題をといてみせ、幾何学の定理を証明してみせ、英会話を学習してみせた。ごく少数を除いて、当時の人々はコンピュータにそのような「知的」な行動が可能だとは全く信じていなかった。研究者らはプライベートでも印刷物でも強烈な楽天主義を表明し、完全に知的な機械が20年以内に製作されるだろうと予測した。ARPAなどの政府機関は、この新しい領域にどんどん資金を注ぎ込んだ。

成果

1950年代末から1960年代にかけて、プログラムと新たな方向性で多くの成功例がみられた。以下に特に影響の大きいものを示す。

手段目標分析

初期のAIプログラムの多くは同じ基本アルゴリズムを採用していた。(ゲームに勝つ、定理を証明するなど)何らかの目標を達成するため、迷路を探索するようにそれに向かって(実際に移動したり、推論したりして)一歩一歩進み、袋小路に到達したらバックトラッキングする。この技法を「手段目標分析」と呼ぶ。

根本的な困難は、多くの問題で「迷路」でとりうる経路の数が天文学的だという点である(これを組合せ爆発と呼ぶ)。探索空間を狭めるためにヒューリスティクスや経験則を用い、解に到達しそうもない経路を排除する。

ニューウェルとサイモンはこのアルゴリズムの汎用版を確立しようと試み、そのプログラムをGeneral Problem Solverと称した。他の探索プログラムは幾何学の問題を解くなど印象的な成果をもたらしている。例えば、Herbert GelernterのGeometry Theorem Prover(1958)、ミンスキーの指導する学生James Slagleが書いた SAINT(1961)などがある。行動計画を立案するために目標を探索するプログラムもある。例えばスタンフォード大学のロボット「シェーキー」の行動を制御するために開発されたSTRIPSがある。

自然言語

AI研究の重要な目標の1つが、コンピューターと英語などの自然言語で会話できるようにすることである。初期の成功例として Daniel Bobrow の STUDENT というプログラムがあり、高校レベルの代数問題を解くことができた。

意味ネットワークは、概念(例えば、「家」、「ドア」)をノードとし、概念間の関係(例えば "has-a")をノード間のリンクで表したものである。意味ネットワークを使った最初のAIプログラムは Ross Quillian が書いたもので、最も成功した(議論も呼んだ)のはロジャー・シャンクのCD理論である。

ジョセフ・ワイゼンバウムのELIZAは、非常にリアルな会話が可能で、ユーザーは人間と会話しているかのような錯覚を覚えるほどだった。しかし、ELIZAは単純なパターンマッチングで応答しているだけで、会話の内容を理解していない。ELIZAはいわゆる人工無脳のさきがけである。

マイクロワールド

1960年代末、MIT人工知能研究所のマービン・ミンスキーとシーモア・パパートは、AI研究をマイクロワールドと名付けた人工的かつ単純な状況に焦点を合わせて行うべきだと提案した。彼らは、物理学などの成功している科学でも摩擦のない平面や完全な剛体などの簡素化したモデルを使うことで基本原理が最もよく理解されたことを指摘した。多くの研究が注目したのは、色つきの様々な形状と大きさの積み木が平らな平面の上に置かれている「積み木の世界」である。

このパラダイムから、実際に積み木が積まれた状況を画像から認識するためのマシンビジョンが発達した。これにはチームを率いたジェラルド・サスマン、制約伝播の概念を確立したデイビッド・ワルツ、パトリック・ウィンストンといった人々が関わった。同じころミンスキーとパパートは積み木を積むことができるロボットアームを製作して、積み木の世界を現実のものとした。このマイクロワールドのパラダイムでの最終成果はテリー・ウィノグラードのSHRDLUである。SHRDLUは普通の英語の文で対話でき、計画を立案し、それを実行する。

楽観主義

第一世代のAI研究者は以下のような予測を述べている。

- 1958年、ハーバート・サイモンとアレン・ニューウェル:「10年以内にデジタルコンピュータはチェスの世界チャンピオンに勝つ」そして「10年以内にデジタルコンピュータは新しい重要な数学の定理を発見し証明する」

- 1965年、ハーバート・サイモン: 「20年以内に人間ができることは何でも機械でできるようになるだろう」

- 1967年、マービン・ミンスキー: 「一世代のうちに(中略)人工知能を生み出す問題のほとんどは解決されるだろう」

- 1970年、マービン・ミンスキー(ライフ誌): 「3年から8年の間に、平均的な人間の一般的知能を備えた機械が登場するだろう」

資金

1963年6月、MITは新たに創設された高等研究計画局(後のDARPA)から220万ドルの資金提供を受けた。この資金で Project MAC が創設され、そこにはミンスキーとマッカーシーが5年前に作ったAIグループも含まれることになった。ARPAは1970年代まで毎年300万ドルを提供し続けた。ARPAはCMUのニューウェルとサイモンの計画にも、スタンフォード人工知能研究所(ジョン・マッカーシーが1963年に創設)にも資金を提供した。もうひとつの重要なAI研究所は1965年、ドナルド・ミッキーがエディンバラ大学に創設した。この4つの研究拠点がAI研究の中心として長く資金供給を受けた。

その資金はほとんどひも付きではなかった。ARPAの部長J・C・R・リックライダーは「プロジェクトではなく人間に投資するのだ」という信念を持っており、研究者には好きなように研究させた。それがMITでの自由奔放な雰囲気を生み出し、ハッカー文化を誕生させることになったが、いつ結果が出るかも分からない「野放し」状態は続かなかった。

AIの冬第1期 1974−1980

1970年代、AIは批判と資金縮小に晒された。AI研究者は直面していた問題の難しさを正しく評価できなかった。楽天主義から予想される成果への期待があまりにも高まったが、結果はその期待に応えられず、AI研究への出資はほとんど無くなった。同じころマービン・ミンスキーがパーセプトロンが排他的論理和を例として、特徴量をそのままでは線形分離可能でないものは学習できないことを示した。これが誤解・誇張されて伝わってしまったことで、データに対してコネクショニズム(またはニューラルネットワーク)の分野は約10年間あまり盛んでなくなった。1970年代後半のAIは一般大衆の受けが悪かったが、新たに論理プログラミングや常識推論などの新たな領域が生まれている。

問題

1970年代前半、AIプログラムの能力は限定的だった。最も進んだものでも小さな問題しか扱えず、どのプログラムも言ってみれば「おもちゃ」だった。AI研究者は1970年代には解決できない根本的限界に直面した。その一部は後に克服されているが、21世紀の今も残っている問題もある。

- コンピュータ性能の限界

- 実用化に当たっては、コンピュータのメモリ容量や速度の不足は深刻であった。例えば、Ross Quillian の自然言語処理プログラムはわずか20の語彙しか扱えず、それが当時のメモリに収まる限界だった。1976年、ハンス・モラベックはコンピュータが知性を持つには数百万倍も強化する必要があると主張した。彼は、人工知能がコンピュータの能力を必要とするのは、航空機が動力を必要とするのと同じだという比喩を示唆した。あるしきい値以下では不可能だが、性能が高まっていけば最終的に容易に知性が得られるだろうと主張した。例えばマシンビジョンについてモラベックは、人間の網膜がリアルタイムで物体の境界や動きを検出する能力を機械で実現するには、毎秒109回の命令実行が可能な(1000 MIPSの)汎用コンピュータが必要だと推定している。2011年現在、実用的なコンピュータビジョンのアプリケーションは10,000から1,000,000MIPSの処理能力を要する。1976年当時の最速のスーパーコンピュータ Cray-1 は、せいぜい80から130MIPSの能力であり、当時のデスクトップ型コンピュータは1MIPSにも達していなかった。

- Intractabilityと組合せ爆発

- 1971年のスティーブン・クックの定理に基づき、1972年、リチャード・カープが指数関数時間(入力のサイズに対して指数関数的になる時間)でしか解けない問題が多数あることを示した (en)。それらの問題の最適解を求めるには、問題がごく小さい場合を除いて極めて多大な処理時間を要する。これは、AIプログラムが「おもちゃ」のような問題に適用している解法の多くを、そのままスケールアップしても使えないことを意味していた。

- 常識的知識と推論

- コンピュータビジョンや自然言語処理といった重要な人工知能アプリケーションの多くは、実世界についての大量の情報を必要とする。見えているものが何なのか、話している内容が何についてなのか、といったことをプログラムが知る必要がある。つまり、そのようなプログラムは話題や見えているものについて子ども程度の知識を持っている必要がある。研究者はそういった情報の量が非常に膨大になることに気付いた。1970年当時、そのような知識を蓄えられるほど巨大なデータベースは構築できなかったし、それだけの情報を蓄積するプログラムをどう書けばいいのかも不明だった。

- モラベックのパラドックス

- 定理証明や幾何学問題を解くといったことはコンピュータにとって比較的簡単だが、人間にとって簡単な顔の識別や物に当たらずに部屋を横切るといったタスクはコンピュータには非常に難しい。1970年代中ごろまでマシンビジョンやロボット工学があまり進展しなかった原因はそのあたりにあった。

- フレーム問題と条件付与問題

- ジョン・マッカーシーのように論理学に基づいているAI研究者らは、論理そのものの構造を変更しないと自動計画における普通の推論を表現できないことを発見した。このため、新たな論理(非単調論理や様相論理)を開発して問題を解こうと試みた。

資金供給の終り

AI研究に資金を供給していた機関(イギリス政府、DARPA、NRCなど)は、成果がないことに苛立ち、AI研究へのひもなしの資金供給がほぼ全て削減対象となった。最初の動きは1966年、機械翻訳の進展のなさを批判した ALPAC の報告書である。2000万ドルを注ぎ込んだ後、NRCは全サポートを終了させた。1973年、イギリスにおけるAI研究の現状を報告した Lighthill report では「壮大な目標」の達成には完全に失敗していることが批判され、イギリスでのAI研究の解体が始まった。この報告書ではAI研究失敗の原因として組合せ爆発問題を挙げている。DARPAはCMUでの音声認識プロジェクトの進展に失望し、毎年300万ドルの資金を停止した。1974年ごろにはAI研究への公的資金提供はほぼ見られなくなった。

ハンス・モラベックは同僚たちの非現実的な予測がこの危機の原因だとし、「多くの研究者が誇張を増大させるクモの巣に巻き込まれた」と述べている。しかし問題はそれだけではない。1969年、マイケル・マンスフィールドの改正案が可決され、DARPAは「方向を定めない基礎研究よりも方向を定めた任務的研究」に資金提供するよう圧力がかかった。60年代のDARPAからの自由奔放な研究への資金提供は継続できなくなった。その代わりに目標がはっきりしているプロジェクト、例えば自律式戦車や戦闘指揮システムなどといったものへ方向性が変化した。

他学界からの批判

一部の哲学者は、AI研究者の主張に強く反論した。最初の批判者の1人 John Lucas は、ゲーデルの不完全性定理が形式体系(コンピュータプログラムなど)では人間が真偽を判断できることも判断できない場合があることを示していると主張した。ヒューバート・ドレイファスは60年代の守られなかった約束を嘲笑し、人間の推論は「記号処理」などではなく、大部分が身体的かつ本能的で無意識なノウハウによっているとし、AIの前提を批評した。1980年、ジョン・サールが提示した中国語の部屋は、プログラムが記号群を使っているからといって、それについて「理解」しているとは言えないことを示したものである(志向性)。記号群が機械にとって何の意味もないなら、その機械は「思考」しているとは言えないとサールは主張した。

これらの批判は、AI研究者には的外れに見えたため、ほとんど真剣に受け取られなかった。intractabilityと常識推論の問題の方が身近で差し迫ったものとして感じられていた。「ノウハウ」または「志向性」が実際のコンピュータプログラムにどんな違いを生じさせるかは不明瞭だった。ミンスキーはドレイファスとサールについて「彼らは誤解しているから、無視してかまわない」と述べた。当時MITで教えていたドレイファスは冷たくあしらわれることになった。後に彼はAI研究者らが「あえて私と昼食をとり、目を合わせないようにした」と述べている。ELIZAの作者ジョセフ・ワイゼンバウムは、同僚たちのドレイファスへの対応が子どもっぽいと感じた。彼もまたドレイファスの考え方には率直に批判していたが、彼は「彼らのやり方が人を扱う方法ではなかったと意図的に明らかにした」

ケネス・コルビーがELIZAを使ってDOCTORというセラピストの会話ボットを書いたことをきっかけとして、ワイゼンバウムはAIについて真剣に倫理的疑念を抱くようになった。コルビーがそれを実際の治療に使えるツールと考えたことにワイゼンバウムは混乱した。確執が始まり、コルビーがそのプログラムへのワイゼンバウムの寄与を認めなかったことで事態は悪化した。1976年、ワイゼンバウムは『コンピュータ・パワー 人工知能と人間の理性』という本を出版し、人工知能の誤用が人命軽視につながる可能性があると主張した。

パーセプトロンとコネクショニズムの暗黒時代

パーセプトロンはニューラルネットワークの一種で、1958年にフランク・ローゼンブラットが発表した。彼はマービン・ミンスキーとは高校の同級生だった。他のAI研究者と同様ローゼンプラットも楽観的で「パーセプトロンは最終的には学習でき、意思決定でき、言語を翻訳できるようになるだろう」と予言している。このパラダイムの研究は60年代に活発に行われたが、ミンスキーとパパートが1969年に出版した著書『パーセプトロン』によって状況が一変した。同書はパーセプトロンに重大な制限があることを示唆し、ローゼンブラットの予測がひどく誇張されたものだったことを示唆していた。その影響は破壊的で、コネクショニズムに関する研究は10年間事実上まったくなされなかった。結局、新世代の研究者が後に研究を再開させ、人工知能の有効な一部となった。ローゼンプラットはミンスキーらの著書が出版されて間もなくボートの事故で亡くなったため、コネクショニズムの復活をその目で見ることはできなかった。

論理、Prologとエキスパートシステム

論理学をAI研究に導入したのはジョン・マッカーシーで、1958年に Advice Taker の提案書でのことである。1963年、ジョン・アラン・ロビンソンがコンピュータで演繹を実装する簡単な方法、導出とユニフィケーションのアルゴリズムを発見した。しかし、マッカーシーと彼の学生達が60年代後半に試みたように、直接的な実装は非常に困難だった。そのプログラムは単純な定理の証明にも天文学的なステップ数を必要とした。論理へのより有効なアプローチは70年代にエジンバラ大学のロバート・コワルスキーが発展させ、間もなくフランスの研究者アラン・カルメラウアーとフィリップ・ルーセルと共同で論理プログラミング言語 Prolog を生み出すことになる。Prologは論理のサブセット(「プロダクションルール」と密接に関連するホーン節)を使い、扱いやすい計算を可能にしている。ルールの考え方は長く影響を及ぼし、エドワード・ファイゲンバウムのエキスパートシステムやアレン・ニューウェルのSoarの基盤となっている。

ドレイファスのように論理的アプローチを批判する者は、人間が問題解決の際に論理をほとんど使わないと指摘する。ピーター・ウェイソン、エレノア・ロッシュ、エイモス・トベルスキー、ダニエル・カーネマンといった心理学者の実験でそれが証明されている。マッカーシーは人間がどうやっているかは無関係だと応えた。彼は、必要とされているのは問題を解くことができる機械であって、人間のように考える機械ではないと主張した。

フレームとスクリプト

マッカーシーの方向性はMITのAI研究者にも批判された。マービン・ミンスキー、シーモア・パパート、ロジャー・シャンクは「ストーリー理解」や「物体認識」といった問題を解決しようとしており、それには人間のように思考する機械が「必要」だった。「椅子」や「レストラン」といった概念を普通に扱えるようにするには、人間が普通に行っているように非論理的な仮定をする必要がある。だが、そういった不正確な概念は論理で表現しづらい。ジェラルド・サスマンは「本質的に不正確な概念を説明するのに精密な言語を使っても、正確さは向上しない」と気付いた。ロジャー・シャンクは彼らの「非論理的」アプローチを "scruffy"、マッカーシー、コワルスキー、ファイゲンバウム、ニューウェル、サイモンといった研究者のアプローチを "neat" と称した。

1975年、ミンスキーは論文で "scruffy" の研究者らが似たようなツールを使っていることを記した。それは何らかの事物についての我々の常識的知識を全て捉えるフレームワークである。例えば、「鳥」という概念を考えたとき、飛ぶ、虫を食べる、などといった一連の事実がすぐさま思い浮かぶ。我々はそれらの事実が常に真実ではないと知っているし、そういった事実を使った推論が「論理的」ではないと知っているが、我々が何かを語り考えるときそういった一群の構造化された前提が文脈の一部を形成している。彼はその構造を「フレーム」と呼んだ。シャンクはある種のフレーム群を「スクリプト」と呼び、それを使って英語の短いストーリーについての質問に答えることに成功した。

第2回AIブーム: 知識工学の時代 1980年–1987年

1980年代、AIプログラムの一形態である「エキスパートシステム」が世界中の企業で採用されるようになり、知識表現がAI研究の中心となった。同じころ、日本政府は第五世代コンピュータプロジェクトでAI研究に積極的に資金提供を行った。また、ジョン・ホップフィールドとデビッド・ラメルハートの業績によりコネクショニズムが復活を果たした。AI研究は再び活況を呈するようになった。

エキスパートシステムの隆盛

エキスパートシステムは、特定領域の知識について質問に答えたり問題を解いたりするプログラムで、専門家の知識から抽出した論理的ルールを使用する。初期の例として、エドワード・ファイゲンバウムらが開発した分光計の計測結果から化合物を特定するDendral(1965)、伝染性血液疾患を診断するMycin(1972)がある。それらがこのアプローチの有効性を示した。

エキスパートシステムは扱う領域を狭くし(それによって常識的知識の問題を回避し)、単純な設計でプログラムを構築しやすくすると同時に運用中も修正が容易となっている。エキスパートシステムは実用的であり、それまでのAIが到達できていなかった段階にまで到達した。

1980年、CMUがDECのためにエキスパートシステムXCONを完成させた。これはDECのVAXシステムの注文に対応したコンポーネントを過不足なく抽出するもので、1986年まで毎年4000万ドルの節約効果を発揮するという大成功を収めた。世界各国の企業がエキスパートシステムの採用を始め、1985年には全世界で10億ドル以上をAIに支出しており、そのほとんどが企業内のAI部門への支出だった。それをサポートする産業も成長してきた。例えばハードウェア企業のシンボリックスやLMI、ソフトウェア企業のインテリコープや Aion がある。

知識革命

エキスパートシステムの能力は内蔵している専門家の知識に由来する。70年代を通して進展していたAI研究における新しい方向性の1つである。「AI研究者らは、それが倹約を旨とする科学の戒律を破ることになると知りつつ、知能が様々な方法で大量の多様な知識を使う能力に基づいている可能性が十分あると疑い始めていた」とパメラ・マコーダックは書いている。「1970年代からの大きな教訓は、知的行動は知識、時にそのタスクに関わる領域の非常に詳細な知識の扱い方に大きく依存しているということだった」 1980年代には知識ベースシステムと知識工学がAI研究の大きな領域となった。

1980年代にはCycプロジェクトも始まった。常識的知識問題に正面から立ち向かう最初の試みであり、一般人が知っているレベルのあらゆる知識を集めた巨大なデータベースを構築するものである。このプロジェクトの創始者ダグラス・レナートは、機械に人間の様々な概念の意味を教えるには近道はなく、人の手で概念を1つずつ学習させるしかないと主張した。プロジェクトの完了には何十年もかかると見られていた。

資金復活:第五世代コンピュータプロジェクト

1981年、日本の通商産業省が570億円をかけた第五世代コンピュータプロジェクトを開始した。自然言語での人間との対話、機械翻訳、画像認識、人間のような推論など、様々な目標を実現するプログラムとマシンを構築することが目的とされていた。"scruffy"側が悔しがったのは、彼らがProlog系の論理プログラミング言語をプロジェクトの主要言語とした点だった。

これに他国も反応し、それぞれ新たな計画を立てた。イギリスは3億5000万ポンドをかけて Alvey プロジェクトを開始した。アメリカでは企業群がコンソーシアム Microelectronics and Computer Technology Corporation (MCC) を結成し、AIおよび情報技術の大規模プロジェクトに資金提供した。DARPAも Strategic Computing Initiative を創設し、1984年から1988年にかけてAI研究への資金供給を3倍に増やした。

コネクショニズムの復活

1982年、物理学者のジョン・ホップフィールド(後にホップフィールド・ネットワークと呼ばれるようになった)は、ある形式のニューラルネットワークが従来とは全く異なる方法で学習し、情報を処理出来ることを示した。同じ頃、デビッド・ラメルハートは、ニューラルネットワークの新たな訓練方法である「バックプロパゲーション」を一般化させた(ポール・ワーボスより数年早く発見した)。それら2つの発見によって、1970年以来下火になっていたコネクショニズムが復活した。

1986年にラメルハートと心理学者のジェームズ・マクレランドの出版した2巻の論文集 Parallel Distributed Processing は、PDPモデルを提唱した。

ニューラルネットワークは1990年代には商業的成功を達成し、簡単な光学文字認識や音声認識のプログラムで使われるようになった。

AIの冬第2期 1987−1993

1980年代商業界でのAIへの関心の高まりは一時的であり、バブル経済の古典的パターンを踏襲した。批判はあったが、AI研究はさらに進歩し続けた。ロドニー・ブルックスとハンス・モラベックはロボット工学を専門とする研究者で、人工知能について全く新しいアプローチを主張した。

AIの冬

「AIの冬」という言葉は1974年の資金供給停止を生き延びた研究者らが作った用語であり、彼らはエキスパートシステムへの熱狂が制御不能となってその後に失望が続くのではないかと心配した。彼らの心配は現実となり、80年代から90年代初めにかけてAI研究は再び資金難に陥った。

最初の兆候は、1987年にAI専用ハードウェアの市場が突然崩壊したことだった。AppleやIBMのデスクトップコンピュータは徐々に性能が向上し、1987年にはシンボリックスなどが生産する高価なLISPマシンを性能的に凌駕するようになった。LISPマシンを購入する理由がなくなり、5億ドルの市場が一瞬で消え去った。

また、XCONなどの成功を収めた初期のエキスパートシステムは、維持コストが非常に高くつくことが判明した。更新が難しく学習機能もなく、入力が間違っているととんでもない答を返してくるという問題もあり、数年前に明らかとなっていた条件付与問題の餌食となった。エキスパートシステムは確かに有効だったが、それはごく限られた状況でのみだった。

80年代末、Strategic Computing InitiativeがAI研究への資金供給をカットした。新たなリーダーを迎えたDARPAはAIが「次の波」ではないと判断し、直近の成果が期待できるプロジェクトに資金を供給することにした。

1991年、第五世代コンピュータプロジェクトも当初掲げた様々な目標を達成することなく完了した。なお、人間と目的もなく普通に会話するなどの目標は2010年ごろまで達成されなかった。他のAIプロジェクトと同様、予測は実際に可能だったものよりずっと高く設定されていた。

実体を持つことの重要性: 新AIと推論の具現化

80年代末、一部の研究者はロボット工学に基づく全く新しいアプローチを主張した。彼らは機械が真の知性を獲得するには「身体」が必要だと信じていた。すなわち、知覚し、動き、生き残り、世界とやりとりできる身体が必要だとした。常識推論のような高いレベルの能力には感覚運動能力が必須であり、抽象的推論は人間の能力としては興味深くないし重要でもないという主張である(モラベックのパラドックス)。彼らは知能を「ボトムアップで」構築することを主張した。

このアプローチは60年代以来下火だったサイバネティックスと制御理論の考え方を復活させた。もう1人の先駆者は70年代末にMITにやってきたデビッド・マーで、それ以前に視覚の理論神経学的研究で成功を収めていた。彼は全ての記号的アプローチ(マッカーシーの論理やミンスキーのフレーム)を廃し、記号処理の前にボトムアップで視覚の物理的機構を理解する必要があると主張した。なお、マーは1980年に志半ばで白血病で亡くなった。

1990年の論文"Elephants Don't Play Chess"で、ロボット工学者ロドニー・ブルックスは物理記号システム仮説を正面から扱い、「世界はそれ自身の最良のモデルである。それは正に常に最新である。知るべき詳細は常にそこにある。秘訣は適切かつ十分頻繁に世界を感知することである」と述べ、記号は常に必要とは限らないと主張した。80年代から90年代にかけて、多くの認知科学者が精神の記号処理モデルを退け、推論には身体が本質的に必要だと主張し、その理論を「身体化された心のテーゼ」と呼んだ。

1993年以降

AIは半世紀以上の歴史を経て、当初のいくつかの目標を達成するまでになった。裏方的ではあるが、産業界の様々な場所で使われ始めている。成功の一因はコンピュータの性能向上だが、具体的な特定の問題に集中した結果でもある。それでもビジネスの世界でのAIの評判は純粋なものとは言えない。1960年代に人間並みの知能をコンピュータで実現するという夢が何故失敗したかについて、AI研究者の間でも意見は一致していないが、少なくともコンピュータの性能が低かったことは非常に大きな障壁となっていた。様々な要因からAIは競合する小さな領域に分かれていき、それぞれ特定の問題やアプローチを扱うようになり、時には「人工知能」の流れを汲んでいることをごまかした新しい名称で呼ばれるようになった。AI研究は従来よりも特定のアプリケーションに対して特化することで地味ではあるが成功を収めた。

マイルストーンとムーアの法則

1997年5月11日、ディープ・ブルーがチェスの世界チャンピオンであるガルリ・カスパロフに勝利した。2005年のDARPAグランド・チャレンジで、スタンフォード大学のロボットカーが優勝した。これは、リハーサルなしで砂漠の中の131マイルの道のりをロボットカーが自律的に走破するレースである。2年後のDARPAアーバンチャレンジでは、市街地を想定した55マイルのコース(障害物があり、法律遵守も求められる)をロボットカーが自律的に走破し、CMUのチームが優勝した。2011年2月、クイズ番組「ジェパディ!」にIBMの質問応答システム「ワトソン」が参加し、圧倒的な差で2人のチャンピオンを破って優勝した。

それらの成功は何か革新的な新パラダイムがもたらしたのではなく、アプリケーションの地道な改良とコンピュータのすさまじい性能向上によるものである。実際、1951年に世界初のチェスプログラムが動作した Ferranti Mark 1 に比べると、ディープ・ブルーは1000万倍の性能である。この劇的な進化はムーアの法則に沿ったもので、コンピュータの速度とメモリ容量は2年ごとに倍増すると予言した法則である。かつて根本問題の1つだった「コンピュータ性能の限界」は徐々に克服されつつある。

知的エージェント

90年代になると「知的エージェント」と呼ばれる新たなパラダイムが広く受け入れられるようになった。初期の研究者らはAIに迫るためにモジュール化された分割統治法を提案していたが、知的エージェントが現代的形態に到達するのはジューディア・パールやアレン・ニューウェルといった研究者がAI研究に決定理論や経済学の概念を持ち込んで以降である。経済学における合理的エージェントの定義と計算機科学におけるオブジェクトまたはモジュールの定義が出会い、知的エージェントのパラダイムが完成した。

知的エージェントは環境を知覚し、成功の確率を最大化する行動をとる。この定義によれば、特定の問題を解く単純なプログラムも「知的エージェント」であり、人間も人間の組織、例えば企業も知的エージェントである。「知的エージェント」パラダイムでは、AI研究は「知的エージェント研究」と定義される。これは初期のAIの定義の一部を一般化したもので、単に人間の知能を研究するのではなく、あらゆる知性を研究対象とすることになる。

このパラダイムにより、孤立した問題を研究し、検証可能で実用的な解法を求めることが意味のあることだと言えるようになった。問題を説明し、経済学や制御理論など抽象的エージェントの概念を扱う他の分野も含めて問題の解決策を共有できる共通語を提供している。いつの日か、完全なエージェントアーキテクチャ(例えば、ニューウェルのSOAR)によって、対話型知的エージェントからより多用途で知的なシステムが構築できるようになることが望まれている。

"neat" の勝利

AI研究者はかつてないほど洗練された数学的ツールを開発し使い始めている。AI研究で解決する必要のあった多くの問題が、数学、経済学、オペレーションズ・リサーチなどの分野の研究者によって既に解決されている。共通の数学的言語を使うことで、より確立された分野と高いレベルで協力でき、測定可能かつ検証可能な成果が生み出され、AIはさらに厳密な「科学的」領域となった。Russell & Norvig (2003)はこれを「革命」であり「"neat"の勝利」に他ならないと記している。

ジューディア・パールの1988年の著書は、AIに確率と決定理論をもたらし、大きな影響を及ぼした。多くの実用化されたツールが、ベイジアンネットワーク、隠れマルコフモデル、情報理論、確率的モデリング、古典的最適化などを活用している。ニューラルネットワークや進化的アルゴリズムといった「計算知能」パラダイムのための正確な数学的記述も発展してきた。

様々な場面で裏方として働くAI

元々はAI研究者が開発したアルゴリズムが大規模システムの一部として使われ始めている。AIは様々な非常に難しい問題を解決してきており、その解法は実用的であることが証明されてきた。例えば、データマイニング、産業用ロボット、物流、音声認識、銀行のソフトウェア、医療診断、Googleの検索エンジンなどが挙げられる。

それらの成功がAIのおかげだということはほとんど知られていない。AIの偉大な技術革新の多くは、達成と同時に計算機科学のありふれたアイテムとして扱われてきた。ニック・ボストロムは「AIの最先端の多くは、十分に実用的で一般的になったとたんAIとは呼ばれなくなり、一般のアプリケーションに浸透していく」と説明している。

1990年代のAI研究者の多くは、意図的に自らの仕事を別の名前で呼んでいた。例えば、インフォマティクス、知識ベース、認知システム、計算知能などである。その理由の一部は、彼らが自分の研究をAIとは全く異なるものだと思っていたからだが、新しい名前をつけることで資金提供を受けられるという面もあった。少なくとも産業界では「AIの冬」をもたらした失敗の影が払拭されておらず、ニューヨークタイムズ紙は2005年に「無謀な夢を見る人とみなされることを恐れ、計算機科学者やソフトウェア工学者は人工知能という用語の使用を避けた」と記している。

1980年代の産業界ではファジィ理論を指す「ファジィ」と並んで、ニューラルネットワークを指す「ニューロ」という言葉がバズワード化し、白物家電製品にも搭載が明記されていた。1990年代に入るとファジィ理論とニューラルネットワークを組み合わせたニューロファジィが様々な製品に搭載されるようになり、白物家電製品にも機能として「ニューロファジィ」等と明記されるようになった。しかし、本来裏方の制御技術であって、利用者から見て目立つ機能では無いため、2000年頃には殆どの製品で明記されなくなっていた。

HAL 9000 はどこに? 2001年前後

1968年、アーサー・C・クラークとスタンリー・キューブリックは、2001年には人間並みか人間を越えた知性を持ったマシンが存在するだろうと想像した。彼らが創造したHAL 9000は、当時のAI研究者が2001年には存在するだろうと予測していたものだった。

マービン・ミンスキーは、「そこで問題は、なぜ我々は2001年になってもHALを実現していないのかだ」と問題提起した。ミンスキーはAIの中心的課題(例えば常識推論)が無視され、多くの研究者がニューラルネットワークや遺伝的アルゴリズムの商用アプリケーションを追求しているのが原因だと信じている。一方ジョン・マッカーシーはいまだに条件付与問題を非難している。レイ・カーツワイルはコンピュータの性能がまだ十分ではないからだと考え、ムーアの法則から人間並みの知能を持った機械が出現するのは2029年だと予測している。ジェフ・ホーキンスは、ニューラルネットワークの研究が人間の大脳皮質の基本的性質を無視し、簡単な問題を解くことに成功した簡単なモデルを好む傾向があると主張している。他にも様々な説明があり、それぞれに対応して進行中の研究計画が存在する。

ディープラーニングに向けた準備

2000年に制限ボルツマンマシンやコントラスティブ・ダイバージェンスの提案が行われた。これらの提案は、2006年にディープラーニングの発明に向かう道筋を作った。

第3回AIブーム: ディープラーニングの時代 2006年−

2005年、遅くとも2045年には人工知能が知識・知能の点で人間を遥かに超越し、科学技術の進歩を主体的に担い世界を変革する技術的特異点(シンギュラリティ)が訪れているとする説をレイ・カーツワイルが著作で発表し物議を醸した。

2006年にジェフリー・ヒントンによりオートエンコーダを利用したディープラーニングが発明された。この発明は人手を介さず特徴量を抽出できる点で、人間による知識表現の必要が無くなり、人工知能における大きなブレイクスルーとなった。この瞬間、長らく暗黒時代を迎えていたコネクショニズムが突如として復活することになった。同時に、人間が知識表現を行うことで生じていた記号接地問題も解決された。

2010年には、インターネットを流れるデータ転送量の増大を受けて、ビッグデータという用語が提唱された。

自動運転研究の進展

2010年代になると自動車や航空機での完全自動運転が実現可能と目されるようになり、自動車を中心に研究が盛んになった。商業販売を目指して公道走行試験が続き、限定的なオートクルーズ機能を持つ車も現れた。

また軍事利用の可能性についても議論されるようになった(この時代にも既に各国は無人戦闘機UCAV、無人自動車ロボットカーを運用していたが、遠隔操作であり完全な自動化には至っていなかった。UCAVは利用されているが、一部操作は地上から行っている)。日本ではP-1(哨戒機)のように戦闘指揮システムに支援用の人工知能が搭載された。

2016年6月、米シンシナティ大学の研究チームが開発した戦闘機操縦用のAIプログラム「ALPHA」が、元米軍パイロットとの模擬空戦で一方的に勝利したと発表された。AIプログラムは遺伝的アルゴリズムとファジィ制御を使用しており、アルゴリズムの動作に高い処理能力は必要とせず、Raspberry Pi上で動作可能。

第3次人工知能ブーム

2012年の物体の認識率を競うILSVRCにおける、GPU利用による大規模ディープラーニング(ジェフリー・ヒントン率いる研究チームがAlex-netで出場した)の大幅な躍進、同年のGoogleによるディープラーニングを用いたYouTube画像からの猫の認識成功の発表により、世界各国において再び人工知能研究に注目が集まり始めた。この社会現象は第3次人工知能ブームと呼ばれる。その後、ディープラーニングの研究の加速と急速な普及を受けて、レイ・カーツワイルが2005年に提唱していた技術的特異点という概念は、急速に世界中の識者の注目を集め始めた。

2013年、国立情報学研究所や富士通研究所の研究チームが人工知能「東ロボくん」で東京大学入試の模擬試験に挑んだと発表した。数式の計算や単語の解析にあたる専用プログラムを使い、実際に受験生が臨んだ大学入試センター試験と東大の2次試験の問題を解読した。代々木ゼミナールの判定では「東大の合格は難しいが、私立大学には合格できる水準」だった。しかし2016年11月、「東ロボくん」は東大合格を諦めるとの報道があった。

2014年、弱いAI「Eugene」が英国のレディング大学で行われたイベントで33%の試験官に人間であると判定されチューリングテストに合格。しかし13歳で英語が母国語でないという設定から物議をかもす。

2014年には、1990年代からシリコンバレーにて医療用システムの研究開発を行い、2010年代からは日本でスーパーコンピュータの研究開発を推進している斎藤元章により、特異点に先立ち、オートメーション化とコンピューター技術の進歩により衣食住の生産コストがゼロに限りなく近づくというプレ・シンギュラリティという概念も提唱された。

ジェフ・ホーキンスが独自の理論に基づき、人工知能の実現に向けて研究を続けた。ジェフ・ホーキンスは、著書『考える脳 考えるコンピューター』の中で自己連想記憶理論という独自の理論を展開している。

ロボット向け人工知能としては、MITコンピュータ科学・人工知能研究所のロドニー・ブルックスが提唱した包摂アーキテクチャという理論が登場している。これは従来型の「我思う、故に我あり」の知が先行する人工知能ではなく、体の神経ネットワークのみを用いて環境から学習する行動型システムを用いている。これに基づいたゲンギスと呼ばれる六本足のロボットは、いわゆる「脳」を持たないにも関わらず、まるで生きているかのように行動する。

実用化の波

2016年3月、米グーグルの子会社DeepMindが作成した囲碁対戦用AI「AlphaGo」が人間のプロ囲碁棋士に勝利。

2016年10月、DeepMindが入力された情報の関連性を導き出し仮説に近いものを導き出す人工知能技術「ディファレンシャブル・ニューラル・コンピューター」を発表。

2016年10月、Microsoftの開発する音声認識ソフトの聞き取りエラー率が人間並みになったと発表。

2016年11月、DeepMindが大量のデータが不要の「ワンショット学習」を可能にする深層学習システムを開発。

2016年11月、DeepMindがAIの学習を従来比で10倍高速化させる新手法を発表。

2016年11月、ニューラル機械翻訳システムGoogle Neural Machine Translationが翻訳にあたって独自に普遍的な言語を作成しており、それに基づいて学習していない言語も翻訳できるという論文が発表される。

2017年1月、初歩的な自己改良プログラムが成功しているとのレポートをMITが公表。

2017年3月、DeepMindがニューラルネットワークが持つ欠陥「破滅的忘却」を回避するアルゴリズムを開発。

2017年6月、DeepMindが関係推論のような人間並みの認識能力を持つシステムを開発。

2017年6月、Facebookが開発したチャットボット同士に会話させていたところAIが英語を基にした独自の言語を生み出したと発表。

2017年8月、DeepMindが記号接地問題(シンボルグラウンディング問題)を解決した。

2010年代後半には、深層学習の実用化成功により、AIの文字を新聞で見かけない日がないほどのAIブームが再来し、企業も人工知能という言葉を積極的に使っている。最終的には人間が生み出した知性が宇宙を満たし、情報処理が物理法則までも支配するというシンギュラリティ仮説や労働が不要の「瑞穂の国」が出現するというプレ・シンギュラリティ仮説が一定の支持を集めるなど、AIに対する期待は高まった。一方でAIによるディストピア論や、現状はAIに対する期待に技術が追い付いていないAIバブルだと批判する声もあった。

デミス・ハサビスは「AIの歴史は誤ったはしごに登っては下りるの繰り返しだった。 『正しいはしご』にたどり着いたのは、大きい」と、AIの冬が再び訪れない可能性に言及した。

医療分野では、患者の大量の医療記録をAIに学習させる事で自殺願望があるかどうかを80%以上の精度で特定できるという研究結果がいくつかあり、AIをセラピストのように人を救う事に活用できないか模索されている。

2018年8月31日、原油高が大きな負担となっていたJALがNECに開発を依頼して新たにAI支援による旅客システムを導入し、約50年続けてきた人間の経験に基づく旅客システム運用を取り止めたことで、空席を殆ど0にまで削減することに成功し、大幅に利益率を向上させた事例が報告された。この事例はディープラーニング以後のAIが絶大な社会的インパクトをもたらす根拠となる事例と言える。

画像生成AIの隆盛

2022年4月にOpenAIから画像生成AIの一種であるDALL-Eが公開される。

2022年7月、Midjourneyのオープンベータ版が公開され、条件次第で極めて人間に近い、あるいは上回る水準でのイラスト生成が簡単に可能だと世界的な話題となる。人間の参加する絵画コンテストにてMidjourney製のイラストが優勝する事態も起きる。

2022年8月にStable Diffusionがオープンソースとして公開。 2022年10月にNovelAIの日本風イラストに強い画像生成機能が公開され、利用するユーザーの増加に伴い日本のpixiv、FANZA等が対応。

2022年以前には画像認識やカメラ補正などソフトウェアの一部として既に高度なAI技術が利用されていたが、「絵を描く」というそれまでAIの苦手分野だと予想されてきた分野に飛躍的な成果が表れたことで生成AI(ジェネレーティブAI)に対し大きく注目が集まった。

また、「AIがイラストレーターの仕事を奪う」「著作権の侵害」とAIアートへの反発も話題となる。2023年、電子情報通信学会は「生成系AIの研究をやみくもに停止すべきではない」と声明を発表。

2025年1月、人気アニメ『エヴァンゲリオン』などのキャラクターのポスターを生成AIを使って作成・販売したとして、男性2人が書類送検された。

ChatGPTの登場

2020年にOpenAIより自然言語処理モデルであるGPT-3が公開される。2022年11月にChatGPTが公開されると、世界的な関心を集めた。対話型の生成AIであるChatGPTはプログラミングを含む多種多様な用途・業務への応用が可能であり、これを利用して論文を書く例も現れている。

2023年2月、MicrosoftはMicrosoft Bingにネット検索と連動可能なAIチャット機能を追加。世界初の対話型AIを搭載する検索エンジンとなった。

2023年3月、GPT-4に米国の模擬司法試験問題を解かせたところ上位10%に匹敵する成績を出した。日本の司法試験でも合格は厳しいがそれなりに高い正答率を示している。

脚注

参考文献